Hinter die Kulissen eines Asynchronous Python SDKs: Zwischen Code-Zauberei und Rate-Limit-Zirkus

Die Kunst des Wartens

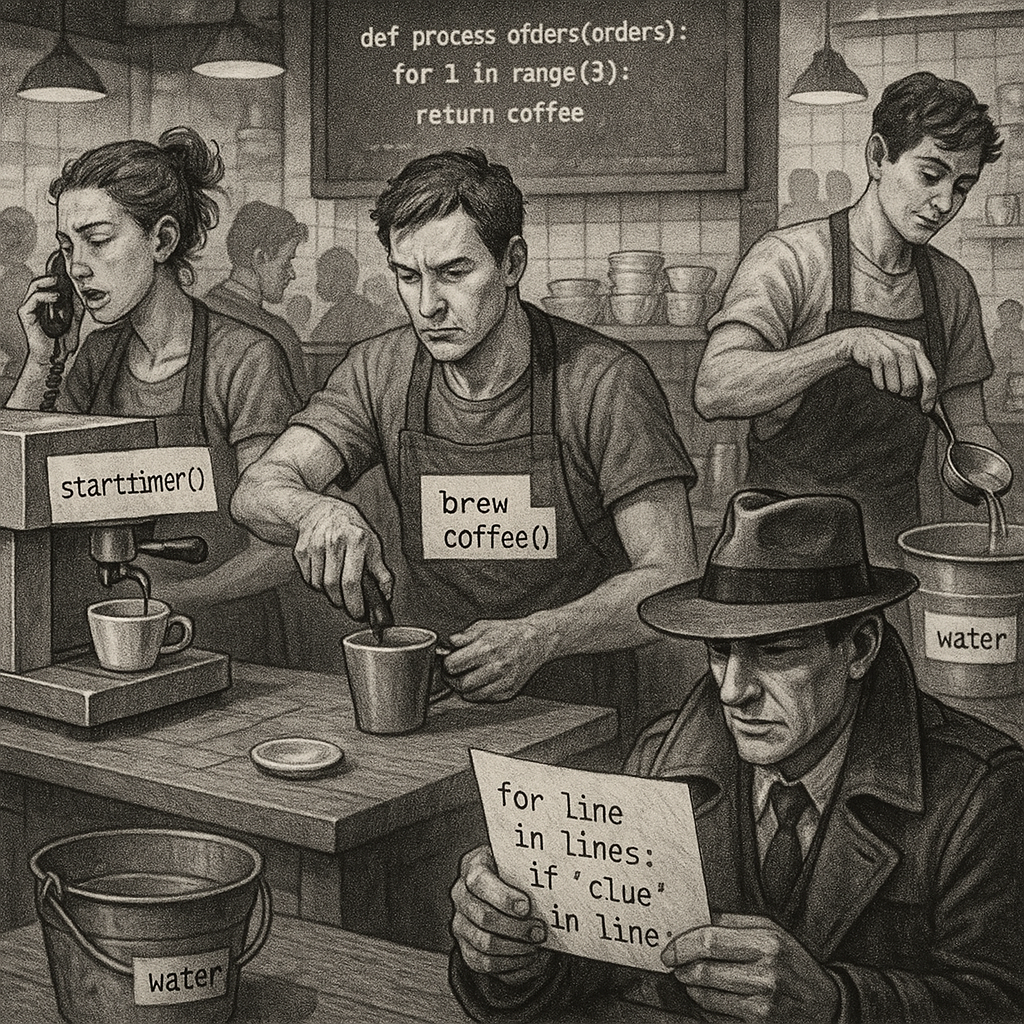

Was haben ein hektischer Barista und dein neuestes Python-Projekt gemeinsam? Genau: Beide müssen blitzschnell arbeiten, um die Kaffeedurstigen oder datenhungrigen API-Calls zu bedienen. Mit Asynchronous Programming betritt allerdings ein besonderer Barista die Bühne – einer, der ganze Bestellungen gleichzeitig annehmen kann! Asynchronous Python SDKs mit Bibliotheken wie aiohttp versprechen genau das: Mehr parallele Verarbeitung, weniger Wartezeiten. Aber Moment mal, wie funktioniert das Ganze?

Stell dir vor, du bist in einem Café, aber anstatt einer Schlange, die darauf wartet, bis die Bestellung einer Person fertig ist, nehmen alle Baristas gleichzeitig Bestellungen auf und arbeiten parallel. Diese Magie nennt sich in der Programmierung "Concurrency". Und der Star dieses Schlachtfelds ist aiohttp, eine Bibliothek, die von asyncio gestützt ist. Es ist die geheime Zutat, die aus langsamen HTTP-Anfragen einen Hochgeschwindigkeits-Tango macht.

Der Tanz um die Rate-Limits

Gleichzeitig bringt jedes Talent seine Herausforderungen mit sich. In der Welt der Programmiersprachen sind das die gefürchteten Rate-Limits. Imagine: Du bist auf eine Party eingeladen, aber plötzlich fordert der Gastgeber einen, etwas langsamer zu tanzen, vielleicht weil der Boden zu rutschig wird. So ähnlich funktioniert das Rate-Limiting: Es schützt APIs vor einer Überladung an Anfragen, die den Server in ein Daten-Niemandsland verwandeln könnten.

Eine beliebte Methode, um dies zu managen, ist der "Token Bucket Algorithmus". Man kann sich das wie eine Wassereimer vorstellen – Wasser (Anfragen) fließen in einem bestimmten Tempo in den Kübel, und jede Anfrage nimmt einen Löffel Wasser heraus. Sobald der Eimer leer ist, müssen alle darauf warten, dass er sich wieder füllt.

Cache mich, wenn du kannst

Aber warum all diese Eile? Weil wir Daten blitzschnell brauchen. Hier kommt der clevere Einsatz von Caching ins Spiel – das Cache-aside-Pattern ist die Kirsche auf unserem Technologiekuchen. Stell dir vor, du bist ein Detektiv in einem Film Noir, auf der Jagd nach Hinweisen (Daten), und du findest einen Speicher, in dem bereits die Antworten auf viele deiner Fragen vorhergesagt werden können!

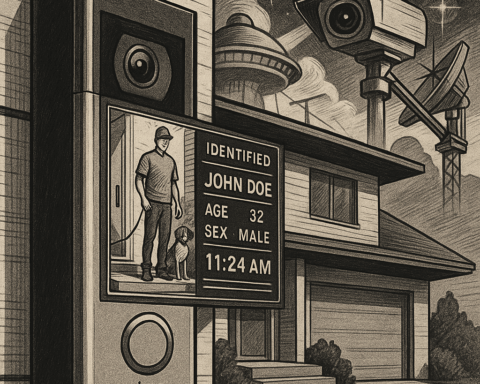

In-memory Caches wie Redis speichern Daten direkt im Speicher (statt auf der schnell ermüdenden Festplatte) und bieten blitzschnelle Zugriffszeiten. Doch aufgepasst: Nicht alle Anfragen sind gleich wichtig, und man muss entscheiden, wann ein Cache die Investition wert ist und wann nicht.

Das große Finale

In dieser aufregenden Welt der Asynchronous Python SDKs bleibt man nie lange am selben Ort stehen. Geschickter Umgang mit concurrency kann deinem Projekt nicht nur einen Schub in der Performance geben, sondern öffnet auch Türen zum effizienteren Arbeiten. Und das alles auf die charmante und zugleich höchst nervenzermürbende Art und Weise, die nur die Merkwürdigkeiten des Codens bieten können – eine Sache, die man einfach lieben muss.

Call to Action

Also, warum nicht das nächste Mal den Barista in deinem Code zum Lächeln bringen und einen Hauch Asynchronität einführen? Es könnte die entscheidende Zutat sein, die deine Projekte zu unvergesslichen Erlebnissen macht. Gib den APIs das, was sie wollen, bevor die Rate-Limits zuschlagen, und fang den innovativen Geist des Caching ein – dein digitales Café wird es dir danken!