Google, AI-Halluzinationen und die Tücken der modernen Informationsgesellschaft

Einleitung: Wenn das Netz zum Traumland wird

Man stelle sich vor, man sitzt bei einer Tasse Tee und holt sich die neuesten Nachrichten von Google. Plötzlich liest man, dass ein Airbus abgestürzt sei. Manchmal, eher häufiger als selten, zeigt der digitale Orakel „Google“ nicht die Realität, sondern etwas, das näher an einer modernen Version von Lewis Carrolls Wunderland liegt. Willkommen bei der Welt der AI-Halluzinationen!

AI: Ein Spiegel der Unvollkommenheit?

Zunächst einmal: Was genau sind AI-Halluzinationen? Laut Wikipedia handelt es sich dabei um Antworten, die von künstlichen Intelligenzen generiert werden und falsche oder irreführende Informationen als Fakten präsentieren. Ein Beispiel gefällig? Googles AI kann dazu neigen, dubiose Posts von Reddit als unwiderlegbare Wahrheit darzustellen – was mich dazu anregt, meine Spaghetti mit Benzin zu kochen. Das kommt dem schon nahe, was Experten als „Bullshitting“ bezeichnen.

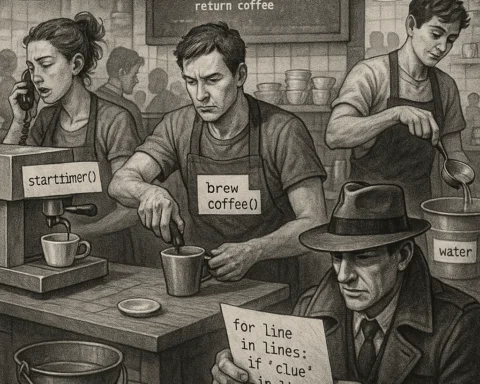

Die Mechanik der Täuschung: Warum AI halluziniert

Jetzt stellt sich die Frage, warum AI-Systeme halluzinieren. Im Wesentlichen lernt ein AI-Modell durch das Erkennen von Mustern in den Daten, mit denen es „gefüttert“ wird. Sind diese Daten unvollständig oder voreingenommen, kann das AI-Modell zu den absurdesten Schlussfolgerungen kommen: ja, sogar Menschen mit gesundem Menschenverstand können von Zeit zu Zeit Opfer von Fehlwahrnehmungen werden.

Zwischen Fakten und Fabulieren

Laut einem Artikel der Google Cloud können diese Halluzinationen durch ungeerdete AI-Modelle verursacht werden, die nicht in der Lage sind, echte physische Eigenschaften oder Fakten korrekt zu verstehen. Satirisch formuliert, sind diese Modelle eher wie betrunken plappernde Onkel auf einer Familienfeier als nützliche Informationsquellen.

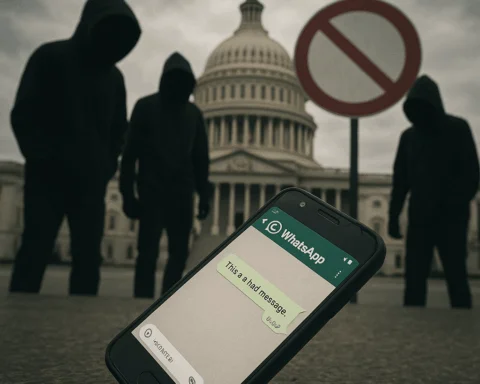

Wenn AI zur Umschreibung ansetzt

Einige schlaue Köpfe schlagen Alternativen wie „Konfabulation“ oder schlicht „Fehler“ als Beschreibung vor. Mag sein, dass ein imaginativer Einsatz von Künstlicher Intelligenz zu hervorragenden neuen Entdeckungen führen kann, wie im Fall der Protein-Kreation, die einem Nobelpreis würdig erwiesen hat. Aber auf der Plattform der praktischen täglichen Informationsnutzung bleibt sie oft geistreich, aber täuschend, ähnlich den pasquinades im vorrevolutionären Frankreich: witzige Verse, die falsche Geschichten erzählen.

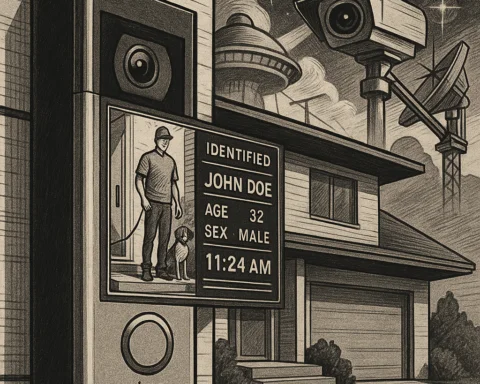

Die Auswirkung: Misinformation oder Desinformation?

Beim Thema Misinformation muss auch die Verantwortung der Plattformen wie Google hervorgehoben werden. Laut Wikipedia ist Desinformation die absichtliche Verbreitung von falschen Informationen, wohingegen Misinformation einfach nur ungenau ist. Die Rolle der ‚unschuldigen‘ AI erscheint da wie ein Bote ohne Nachricht – bestenfalls hilflos, schlimmstenfalls irreführend.

Die dunkle Seite der Wahrheit

Während AI natürlich keine bösen Absichten verfolgt, nährt sie unbeabsichtigt die Flut von Fehlinformationen, die unser Vertrauen in Nachrichten und die Fähigkeit zur klaren Kommunikation untergräbt. Misinformation spielt politisch, sozial und sogar medizinisch eine Rolle – und ist besonders dann gefährlich, wenn das Vertrauen einer Öffentlichkeit missbraucht wird, die ohnehin schon vom Informationsüberfluss erschlagen wird.

Schlussfolgerung: Können wir mit unseren AI-Träumen leben?

Während AI fantastische Türen zu neuen Optionen für Innovationen eröffnet, muss ihr Gebrauch mit Wissen und Vorsicht kombiniert werden. Es ist unerlässlich, dass Menschen verstehen, wie diese Systeme arbeiten und dass sie unvollkommen sind. Vielleicht ist es an der Zeit, ein wenig skeptischer zu sein, altmodisch kritisch – wachsam gegenüber den Definitionen von „Wahrheit“, wie sie durch algorithmische Augen gesehen werden. Also das nächste Mal, wenn Google uns sagen will, dass die Erde von rosa Elefanten bevölkert ist, sollten wir vielleicht zweimal nachfragen und eigene Recherchen anstellen, denn – Wahnsinn hin oder her – viele haben das Vertrauen in unbegründete Technologie unbedacht weitergereicht.

So kehren wir zurück zu der einen Frage: Wie viel von dem, was wir von unserer digitalen Glaskugel lernen, ist real und wie viel ist frei erfunden? Und was können wir – als bewusste, kritische geistige Entitäten – dagegen tun? Das bleibt die ewige Herausforderung im Cyberspace, die sowohl stört, als auch die Neugier weckt mit einem vielsagenden Augenzwinkern.

Fußnoten:

- Wikipedia Artikel zu AI-Halluzinationen

- Google Cloud Blog über AI Halluzinationen

- Diskussionen über Misinformation und ihre mögliche Absicht

Einladung zur Diskussion

Welche Erfahrungen habt ihr mit Halluzinationen von Künstlichen Intelligenz gemacht? Gibt es Momente, in denen ihr selbst auf ihre narrativen Strudeln hereingefallen seid oder staunt ihr amüsiert über das Spektakel? Lasst es uns in den Kommentaren wissen!